文章目录

- 数据输入范围和权重初始化

- 数据范围对权重初始化的影响

- 示例代码

- 输入数据标准化

- 说明

- 其他注意事项

- 常见初始化方法

- 常见的权重初始化方法

- 示例代码

- 说明

- 模型默认初始化方法,会不会导致Loss为inf

- 示例

- 说明

- 初始化权重导致 Loss 为 `inf`

- 避免 Loss 为 `inf` 的建议

- 示例:检查损失是否为 `inf`

数据输入范围和权重初始化

是的,初始化权重和数据范围之间确实有关系。输入数据的范围和分布会影响神经网络的训练过程,因此权重初始化需要与之配合,以确保模型能够有效地学习和收敛。

数据范围对权重初始化的影响

-

输入数据归一化/标准化:

- 归一化/标准化输入数据可以确保所有特征具有相似的尺度,从而防止某些特征主导模型的学习过程。

- 例如,将输入数据归一化到 [0, 1] 或标准化到均值为 0、标准差为 1 的分布。

-

权重初始化方法的选择:

- 不同的初始化方法适用于不同的激活函数和数据范围。

- 例如,使用 ReLU 激活函数时,He 初始化通常效果更好;使用 tanh 或 sigmoid 激活函数时,Xavier 初始化通常效果更好。

示例代码

以下是如何根据输入数据范围进行权重初始化的示例:

输入数据标准化

import torch

import torch.nn as nn

import torch.optim as optim

from sklearn.preprocessing import StandardScaler

# 生成示例数据

x_data = torch.randn(100, 10)

y_data = torch.randn(100, 1)

# 标准化输入数据

scaler = StandardScaler()

x_data = torch.tensor(scaler.fit_transform(x_data), dtype=torch.float32)

# 定义简单的神经网络

class SimpleModel(nn.Module):

def __init__(self, input_dim, output_dim):

super(SimpleModel, self).__init__()

self.linear1 = nn.Linear(input_dim, 50)

self.linear2 = nn.Linear(50, output_dim)

self._initialize_weights()

def _initialize_weights(self):

nn.init.kaiming_normal_(self.linear1.weight, nonlinearity='relu')

nn.init.kaiming_normal_(self.linear2.weight, nonlinearity='relu')

nn.init.constant_(self.linear1.bias, 0)

nn.init.constant_(self.linear2.bias, 0)

def forward(self, x):

x = torch.relu(self.linear1(x))

x = self.linear2(x)

return x

# 初始化模型

input_dim = x_data.shape[1]

output_dim = y_data.shape[1]

model = SimpleModel(input_dim, output_dim)

# 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 训练步骤

output = model(x_data)

loss = criterion(output, y_data)

print(f"Loss: {loss.item()}")

说明

- 数据标准化:使用

StandardScaler将输入数据标准化,使其均值为 0,标准差为 1。这样可以确保数据范围在一个合适的尺度上。 - 权重初始化:使用 He 初始化(

nn.init.kaiming_normal_)来初始化权重,这是因为 ReLU 激活函数通常与 He 初始化配合得很好。 - 模型定义:定义了一个简单的神经网络模型,并在构造函数中调用了

_initialize_weights方法来初始化权重。

其他注意事项

- 数据归一化:如果输入数据的范围在 [0, 1] 或 [-1, 1],可以考虑使用

MinMaxScaler进行归一化。 - 特征缩放:如果不同特征的范围差异较大,特征缩放可以帮助加速梯度下降算法的收敛。

- 权重初始化的选择:根据输入数据范围和激活函数选择合适的权重初始化方法,可以有效地防止梯度消失或梯度爆炸问题,提高模型的训练效果。

通过合理选择权重初始化方法和对输入数据进行适当的预处理,可以确保模型更稳定和高效地训练。如果您有更多问题或需要进一步的帮助,请告诉我!

常见初始化方法

神经网络的权重初始化对于模型的训练效果至关重要。在 PyTorch 中,有多种常见的权重初始化方法,可以根据具体情况选择最适合的方法。以下是一些常见的初始化方法:

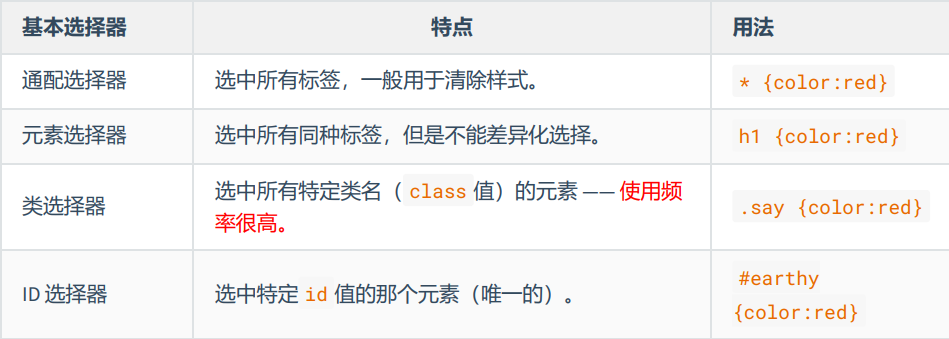

常见的权重初始化方法

-

零初始化 (Zero Initialization)

- 将所有权重初始化为零。

- 这种方法一般不推荐,因为所有神经元的输出将是相同的,导致梯度更新也是相同的,从而破坏了模型的学习能力。

-

正态分布初始化 (Normal Initialization)

- 从均值为0,标准差为指定值的正态分布中采样。

- 通常使用

torch.nn.init.normal_方法。

-

均匀分布初始化 (Uniform Initialization)

- 从指定区间的均匀分布中采样。

- 通常使用

torch.nn.init.uniform_方法。

-

Xavier 初始化 (Xavier Initialization)

- 适用于激活函数为

tanh或sigmoid的网络。 - 使得每一层的输入和输出的方差尽可能相同。

- 使用

torch.nn.init.xavier_normal_或torch.nn.init.xavier_uniform_方法。

- 适用于激活函数为

-

He 初始化 (He Initialization)

- 适用于激活函数为

ReLU的网络。 - 使用

torch.nn.init.kaiming_normal_或torch.nn.init.kaiming_uniform_方法。

- 适用于激活函数为

示例代码

以下示例展示了如何使用这些初始化方法:

import torch

import torch.nn as nn

class SimpleModel(nn.Module):

def __init__(self, input_dim, output_dim):

super(SimpleModel, self).__init__()

self.linear1 = nn.Linear(input_dim, 50)

self.linear2 = nn.Linear(50, output_dim)

self._initialize_weights()

def _initialize_weights(self):

# 正态分布初始化

nn.init.normal_(self.linear1.weight, mean=0, std=0.01)

nn.init.normal_(self.linear2.weight, mean=0, std=0.01)

# 均匀分布初始化

# nn.init.uniform_(self.linear1.weight, a=-0.01, b=0.01)

# nn.init.uniform_(self.linear2.weight, a=-0.01, b=0.01)

# Xavier 初始化

# nn.init.xavier_normal_(self.linear1.weight)

# nn.init.xavier_normal_(self.linear2.weight)

# He 初始化

# nn.init.kaiming_normal_(self.linear1.weight, nonlinearity='relu')

# nn.init.kaiming_normal_(self.linear2.weight, nonlinearity='relu')

# 偏置初始化为零

nn.init.constant_(self.linear1.bias, 0)

nn.init.constant_(self.linear2.bias, 0)

def forward(self, x):

x = torch.relu(self.linear1(x))

x = self.linear2(x)

return x

# 初始化模型

input_dim = 10

output_dim = 1

model = SimpleModel(input_dim, output_dim)

# 打印网络每层参数

for name, param in model.named_parameters():

print(f"Layer: {name} | Size: {param.size()} | Values: {param[:2]}\n")

说明

- 正态分布初始化:使用

nn.init.normal_方法将权重初始化为从正态分布中采样的值。 - 均匀分布初始化:可以使用

nn.init.uniform_方法,将权重初始化为从均匀分布中采样的值。 - Xavier 初始化:可以使用

nn.init.xavier_normal_或nn.init.xavier_uniform_方法,根据输入和输出层的大小调整初始化值。 - He 初始化:可以使用

nn.init.kaiming_normal_或nn.init.kaiming_uniform_方法,根据激活函数(如 ReLU)调整初始化值。 - 偏置初始化:将偏置初始化为零,使用

nn.init.constant_方法。

通过这些方法,您可以灵活地初始化神经网络的权重,从而提高模型的训练效果和收敛速度。如果您有更多问题或需要进一步的帮助,请告诉我!

模型默认初始化方法,会不会导致Loss为inf

在 PyTorch 中,如果不显式设置权重初始化,模型层会使用默认的初始化方法。具体的默认初始化方法取决于层的类型。以下是一些常见层的默认初始化方法:

-

线性层 (

nn.Linear)- 权重:使用均匀分布

U(-sqrt(k), sqrt(k))初始化,其中k = 1 / input_features。 - 偏置:初始化为零。

- 权重:使用均匀分布

-

卷积层 (

nn.Conv2d)- 权重:使用均匀分布

U(-sqrt(k), sqrt(k))初始化,其中k = 1 / (in_channels * kernel_size * kernel_size)。 - 偏置:初始化为零。

- 权重:使用均匀分布

示例

以下示例展示了 PyTorch 默认的权重初始化方法:

import torch

import torch.nn as nn

class SimpleModel(nn.Module):

def __init__(self, input_dim, output_dim):

super(SimpleModel, self).__init__()

self.linear1 = nn.Linear(input_dim, 50)

self.linear2 = nn.Linear(50, output_dim)

def forward(self, x):

x = torch.relu(self.linear1(x))

x = self.linear2(x)

return x

# 初始化模型

input_dim = 10

output_dim = 1

model = SimpleModel(input_dim, output_dim)

# 打印网络每层参数

for name, param in model.named_parameters():

print(f"Layer: {name} | Size: {param.size()} | Values: {param[:2]}\n")

说明

- 线性层默认初始化:在上面的

SimpleModel中,self.linear1和self.linear2的权重会默认使用均匀分布进行初始化,偏置初始化为零。

初始化权重导致 Loss 为 inf

权重初始化不当确实可能导致损失(loss)为 inf 或 NaN。常见原因包括:

- 权重过大:权重初始化值过大,导致前向传播时激活值过大,从而在计算损失时产生溢出。

- 不适当的激活函数和初始化方法:例如,使用

ReLU激活函数时,权重初始化值过大可能导致梯度爆炸。 - 数值不稳定:例如,在使用对数或指数运算时,输入值过大可能导致数值溢出。

避免 Loss 为 inf 的建议

- 使用适当的初始化方法:根据激活函数选择合适的权重初始化方法,例如使用 He 初始化与

ReLU激活函数配合,使用 Xavier 初始化与tanh或sigmoid激活函数配合。 - 梯度剪裁:在训练过程中对梯度进行剪裁,防止梯度爆炸。

- 检查输入数据:确保输入数据没有异常值,例如过大的数值或缺失值(NaN)。

- 调整学习率:学习率过大也可能导致数值不稳定,可以尝试减小学习率。

示例:检查损失是否为 inf

import torch

import torch.nn as nn

import torch.optim as optim

class SimpleModel(nn.Module):

def __init__(self, input_dim, output_dim):

super(SimpleModel, self).__init__()

self.linear1 = nn.Linear(input_dim, 50)

self.linear2 = nn.Linear(50, output_dim)

def forward(self, x):

x = torch.relu(self.linear1(x))

x = self.linear2(x)

return x

# 初始化模型

input_dim = 10

output_dim = 1

model = SimpleModel(input_dim, output_dim)

# 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 生成示例数据

x = torch.randn(16, input_dim)

y = torch.randn(16, output_dim)

# 前向传播

output = model(x)

loss = criterion(output, y)

# 检查损失是否为 inf

if torch.isinf(loss):

print("Loss is infinite. Please check the initialization and input data.")

else:

print(f"Loss: {loss.item()}")

通过这些方法,您可以确保模型的权重初始化适当,并避免损失为 inf 的情况。如果您有更多问题或需要进一步的帮助,请告诉我!